Владельцы сайтов часто ищут возможность сделать бесплатный аудит сайта онлайн. Но бесплатно в автоматических сервисах они могут получить только анализ основных параметров сайта и выявить часть ошибок, например, ссылки на 404 страницы. На самом деле, ничего сложного в поверхностном аудите сайта нет и выполнить его самостоятельно, своими руками может практически любой владелец сайта. Итак, приступим.

1. Инструменты анализа сайта.

Для анализа нам потребуется несколько простых инструментов: парсер сайта и парсер параметров сайта. На сегодня на рынке существует множество продуктов, я же, когда не требуется какой-то глубокой аналитики, предпочитаю простые и бесплатные варианты.

Netpeak Spider - легкая в управлении и бесплатная программа.

Скачать ее можно на сайте компании. От вас потребуется только регистрация на свой емайл.

Нетпик Спайдер позволяет быстро и легко выявить дубли страниц, наличие ссылок на 404 страницы. Достаточно только ввести адрес своего сайта и нажать кнопку "Пуск". Спустя некоторое время - необязательно ждать конца сканирования, можно просто нажать "Стоп" - вы во вкладке "Ошибки" сможете увидеть наиболее очевидные проблемы вашего сайта. Чтобы выяснить, откуда сканер нашел у вас страницу с 404 ответом, нажмите правой клавишей на ошибочной странице и выберите вариант "Ссылки на эту страницу". Теперь вы знаете, где стоят ссылки на страницы, которых нет, и можете убрать их.

RDS bar - плагин к браузеру для определения параметров сайта. Установить его можно либо из магазина приложений к браузеру, или зайдя на

сайт компании-производителя.

РДС бар показывает множество полезной информации, но вам для анализа потребуется не так уж и много. В частности можно быстро сравнить индексацию в Яндекс и Гугл, если она существенно отличается, то у вашего сайта, скорей всего, проблемы с дублями и битыми страницами. Также через RDS легко попасть на сервисы по поиску внешних ссылок, посмотреть, как выглядит ваш robots.txt и выяснить другую полезную информацию о собственном сайте.

Если у вас еще не подключены

Яндекс.Метрика и

Google Analytics, самое время это сделать. Для этого потребуется регистрация в сервисах и размещение в шаблоне сайта кода счетчика. По традиции код счетчика ставят в нижней части - это гарантирует, что учтены будут только полные загрузки страницы. Почему ставить сразу две системы? На сегодня и Яндекс, и Гугл скрывают поисковые запросы, по которым пользователи перешли на сайт. Чтобы эта информация хотя бы частично была вам известна, потребуется установка кода счетчика от каждой из систем. Дополнительным плюсом от использования аналитики будет в будущем возможность ретаргетинга в рекламных системах: вы сможете показывать рекламу тем, кто посещал ваш сайт.

Дополнительно я бы рекомендовал установку счетчика от

Liveinternet.ru - ради удобных для глаза неопытного пользователя отчетов.

2. Анализ посетителей и посещаемости сайта.

Если счетчики от Я.Метрики и Гугл Аналитикс ранее не были установлены, то выполнить этот анализ вы не сможете. Вам придется, как минимум, несколько недель подождать, пока накопится статистика посещаемости.

Проверяем показатели.

Глубина просмотра или число просмотров к числу посетителей. Чем больше, тем лучше. Для корпоративных сайтов нормальным будет соотношение выше 3. Для интернет-магазинов - от 10. Логика проста и опирается на типовой путь пользователя по сайту. На корпоративном сайте пользователь интересуется конкретной услугой и заканчивает путь просмотром контактов. Для интернет-магазинов характерен длительный выбор, сравнение, переход в корзину и оформление заказа. Для инфосайтов, созданных ради посещаемости из поиска, тоже желательно повышать этот показатель (обычно у таких сайтов он равен 1.0-1.2) - это позволит приблизиться к показателям для популярных журналов и избежать проблем с индексацией и ранжированием. Если данный показатель ниже средних значений, необходима работа со структурой сайта и перелинковкой.

Показатель отказов. Процент посетителей, которые покинули вашу страницу после первого просмотра. В Яндексе данный показатель измеряется несколько иначе: в него входит процент посетителей, которые покинули сайт быстрее, чем через 15 секунд. В гугле показатель показывает процент тех, кто ограничился одной страницей, поэтому одностраничники в гугле будут всегда иметь показатель отказов, равный 100%.

Время на сайте. Параметр, говорящий, сколько человек провел времени на сайте. Для большей достоверности стоит делить его на число просмотренных страниц. Если в этом случае время становится достаточным только для того, чтобы мельком взглянуть на страницу - у вашего сайта слишком велика доля случайной посещаемости.

Точки входа. У каждого сайта есть страницы, которые агрегируют основную входящую посещаемость. Выявление таких страниц позволит прояснить ситуацию с теми страницами, которые планировались как точки входа, но так ими и не стали. Пример: на сайте "муж на час" есть страница по услуге "ремонт сантехники", но среди точек входа такая страница не числится - значит, есть проблемы с релевантностью запросу.

Динамика посещаемости с поиска. Один из любимых графиков всех оптимизаторов. Если ваш сайт не показывает положительной динамики длительное время, значит, вы залипли, достигли максимума возможностей своего сайта в части поисковой оптимизации. Дальше нужно или дожимать по позициям, или менять структуру, или менять стратегию.

Карта кликов. Показывает какие пункты меню, ссылки и кнопки востребованы больше других. Это позволяет экспериментировать с инфоблоками, добиваясь максимальной кликабельности по ссылкам, а также выявить точки на сайте, которые кажутся посетителям интерактивными, но таковыми по факту не являются: например, иллюстрации к тексту нередко кажутся пользователям переходом в портфолио. Почему бы в таком случае (при наличии кликов в такое изображение) не сделать картинку действительно переходом в портфолио?

3. Анализ позиций сайта.

Для анализа позиций вам потребуется сервис измерения позиций. Их достаточно много:

serprating.ru. Я предпочитаю пользоваться сервисом

Topvisor.ru - дешево, быстро, есть дополнительный сервис по сбору ключей. Вы можете выбрать любой другой.

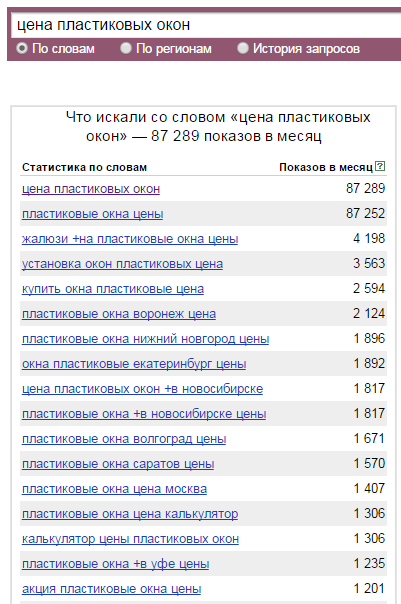

Чтобы измерять позиции, надо сначала их собрать. Если вы не занимались сбором ключей ранее, то или дождитесь лекции по сбору ключей, или поступите проще: возьмите основные ключи для своего сайта, соберите со своего сайта заголовки пунктов меню, ведущих на разделы. Проверьте собранное на точную частоту в

wordstat.yandex.ru, затем проверяйте позиции сайта для ключей, которые имеют ненулевую частотность.

Оптимально настроить две группы по своему сайту: контрольные ключи (30-100 штук), которые вы будете проверять каждый апдейт для отслеживания динамики. И полное семантическое ядро, которое будете проверять раз в месяц или реже, чтобы не тратить большое количество средств на это.

4. Анализ контента (текста) сайта.

Проверить текст можно и нужно по нескольким показателям: уникальность, водность, наличие синонимов и топонимов, наличие связанных фраз.

Уникальность проверяется сегодня на множестве сервисов, одними из самых популярных являются

Адвего Плагиатус и проверка на сервисе

text.ru. К проверке уникальности надо относиться следующим образом: разделять для себя копирование текстов из другого источника и невозможность уникализации, например, при описании товаров, услуг, каких-то технологических процессов. Если копирование чужих текстов является ошибкой, то попытка добиться 100% уникальности при работе с текстами для товаров обречена на провал и существенно ничего для вас не изменит при продвижении сайтов. На сегодня поиск неплохо умеет распознавать какого вида контент перед ним и не относить неуникальность описаний товаров к пессимизирующим факторам для оценки сайта.

Для проверки "водности" текста никаких популярных сервисов нет. Но даже поверхностного анализа достаточно, чтобы понять, что текст раздут и вряд ли будет относиться поиском к качественным. Количественной характеристикой для определения водности текста будет, например, среднее число слов в предложении. Если этот параметр выше 5-7 слов для текста, ориентированного на продажи - он водный. Если это текст из технического описания, то длина должна быть выше 5-7 слов. Другим параметром может служить избыточное употребление прилагательных, наречий и других частей речи, ничего не добавляющих к смыслу текста, но делающих его больше. Еще одним негативным фактором может стать отсутствие или низкая плотность терминов, характерных для данной ниши. Подводя итог, хороший текст для корпоративного сайта должен состоять из коротких предложений, содержать специфичные термины и при этом вызывать желание дочитать его до конца.

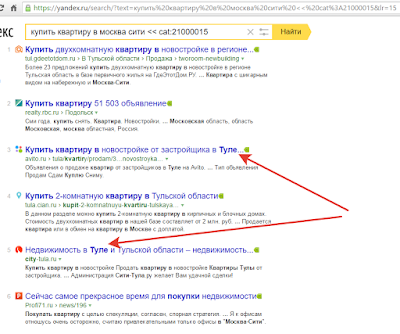

Выявить возможные синонимы и топонимы для написания в тексте можно с помощью подсветки. Введите свою фразу в поиск и соберите фразы, которые выделены жирным. Если в ваших текстах этих фраз нет, то, вероятно, вы что-то упускаете.

Связанные фразы - это фразы, которые не входят в семантическое ядро, но сопровождают тексты по вашим ключевым запросам. Например, для запроса "фотоаппарат" связанным будет слово "объектив". Как выявлять такие фразы, мы поговорим в одной из следующих лекций.

5. Анализ работы, скорости сайта.

Для изучения скорости работы сайта есть отдельный отчет в Я.Метрике. Если ваш сайт грузится дольше 400-700мс, то у вас могут быть проблемы с индексацией и ранжированием.

6. Анализ внешних ссылок сайта.

Внешние ссылки принято анализировать с помощью сторонних сервисов, которые собирают информацию о ссылках со всего интернета и предоставляют вам выборку по вашему сайту. Понятно, что изучить весь интернет эти сервисы не могут, поэтому не могут и похвастаться полнотой своей информации. Однако, с чем-то работать все равно нужно, так что просто держите в голове, что, во-первых, информация о ссылочном в таких сервисах запаздывает на 2-3 месяца, а, во-вторых, найденное число ссылок можно смело умножать на два, а то и на три.

Так как два наиболее полных сервиса платные, мы воспользуемся бесплатным вариантом для поверхностного анализа ссылок -

Linkpad.ru.

График динамики прироста ссылочного говорит нам о том, как покупались/проставлялись ссылки для исследуемого проекта. В идеале мы должны видеть постоянный прирост. Если мы видим быстрый выход на максимальное значение и потом длительный баланс на этом уровне - мы видим классическое ссылочное продвижение через агрегатор или биржу арендных ссылок.

Здесь на графике ссылочное моего блога. Видно, что число ссылок растет от месяца к месяцу.

А это коммерческое продвижение одного из московских сайтов. Видны и ссылочный взрыв, и насыщение. Будьте уверены, поиск видит это не хуже нас с вами.

Еще один важный анализ ссылок - это распределение по анкорам. Не секрет, что для имитации естественности, на проект должно вести множество так называемых безанкорных ссылок. Выявить - так это или нет с вашим проектом, можно просмотрев эти анкоры.

Приведенный скрин из Линкпада нам особо ничего не говорит. Чтобы выяснить полную картину, надо выкачать всю базу ссылок и сгруппировать их по тексту анкора, чтобы высчитать долю каждого в общей массе. Безанкорных и брендовых анкоров, несовпадающих с ключами из ядра, должно быть более половины, а лучше - от 70% от общего числа.

7. Анализ юзабилити сайта.

Коммерческим факторам уделяется все больше внимания в работе по продвижению сайта. Проиллюстрируем, о чем речь.

Наличие телефона в верхней части сайта.

Скидки и акции в видимой части сайта.

Наличие понятной и удобной витрины/каталога.

Контакты в нижней части сайта. Наличие большого количества способов связи с компанией.

Вызов замерщика/установщика. Форма обратной связи.

Калькуляторы и иной полезный интерактив на сайте.

Онлайн-помощник. Но только если с обратной стороны действительно кто-то есть.

Туда же еще относим наличие видео, графического материала, карты проезда, адреса, юридических реквизитов, наличие информации о сертификации, лицензировании, информация об офисе, сотрудниках и т.д., и т.п. Если ничего из этого нет, то должны возникать вопросы по доверию к такой компании.

-----

На этом позволю себе закончить данную статью. Здесь не охвачено еще много моментов, нет анализов тэгов, верстки, сниппетов и многого другого. Но описанного уже достаточно, чтобы начать думать, что не так с вашим сайтом. В следующей лекции мы разберемся, как быстро и легко собрать и группировать ключи для вашего сайта.

-----

Это лекция из

сокращенной бесплатной версии курса по самостоятельному поисковому продвижению для владельцев сайтов и начинающих оптимизаторов. Опыт показывает, что предлагаемых в курсе мер достаточно для вывода в топ 7 из 10 корпоративных или информационных сайтов.

Предварительная запись на полный курс по самостоятельному продвижению сайтов.